Hao Li, científico en computación y gran innovador tecnológico, dio una charla hace unos pocos días en el Foro Económico Mundial en Davos sobre deepfake, del que es creador.

Muestra orgullo y preocupación sobre lo ideado. Es que con esta tecnología se puede poner en la boca de alguien en forma absolutamente convincente algo que nunca dijeron y con lo que probablemente ni siquiera estén de acuerdo, pero también da gran flexibilidad y agrega nuevas dimensiones a las posibilidades en producción fílmica, así como en el terreno de la medicina, entre otros.

Deepfake es una tecnología que usa la inteligencia artificial (IA) para alcanzar un “aprendizaje profundo” de una persona. Sobre la base de una enorme cantidad de información, es decir, innumerables fotos, grabaciones y videos, que incluyan todas las expresiones faciales posibles y las entonaciones de voz de la persona a la que se quiere falsificar, la IA puede hacer una síntesis de estas características y visualmente mostrar a la persona señalada expresándose en forma verosímil pero falsa. La precisión del deepfake avanza a una velocidad impresionante, de manera que un video elaborado con esta tecnología ahora es mucho más creíble que uno producido hace seis meses con el mismo fin. Es más, la última generación de esta tecnología puede distorsionar lo dicho por una persona en tiempo real, como explica Hao Li. Esto puede tener un uso muy positivo, como la traducción simultánea en diversos idiomas ¡pero también puede haber una sustitución del contenido de un discurso simultáneo a su transmisión!

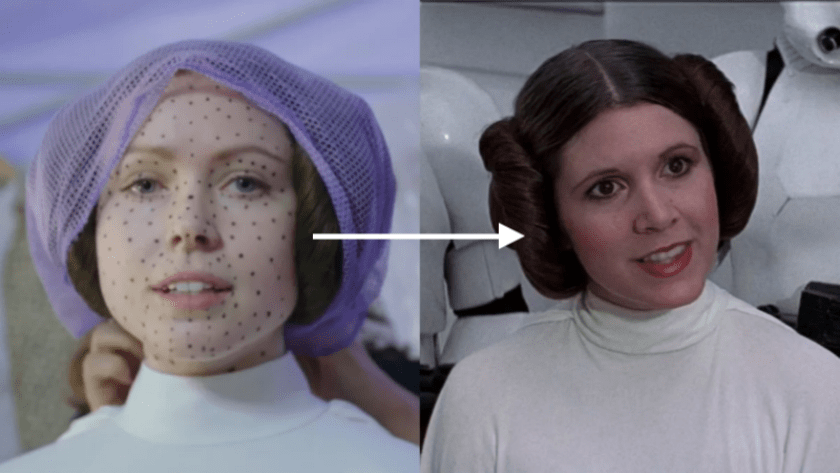

Entre los usos positivos de esta nueva tecnología puede mencionarse la posibilidad de crear videos, películas y grabaciones en forma ágil y a menor costo que por los medios tradicionales, o incluso resolver problemas que hasta hace poco eran irremediables. Este último fue el caso de la película Rogue One una historia de Star Wars (2016), cuya actriz principal Carrie Fisher, que representaba a la Princesa Leia, falleciera antes de que se terminara el rodaje de la cinta. Gracias a la adopción de la técnica deepfake, la actriz Ingvild Deila pudo desempeñarse en el rol de Carrie, aparentando ser esta última en algunas escenas, lo que permitió completar la producción.

En el mundo de la medicina, la inteligencia artificial puede ayudar a pronosticar una serie de enfermedades como, por ejemplo, distintos tipos de tumores. Para ello se requiere una enorme cantidad de información, como tomografías computarizadas, imágenes de resonancia magnética y placas de rayos-X. Pero normalmente no se dispone de ésta en cantidades suficientes (por respeto a la privacidad de los pacientes), de forma que el deepfake puede proporcionar las imágenes faltantes, creadas artificialmente, para alimentar los algoritmos de aprendizaje profundo, complementando así la información existente y contribuyendo a mejorar los diagnósticos.

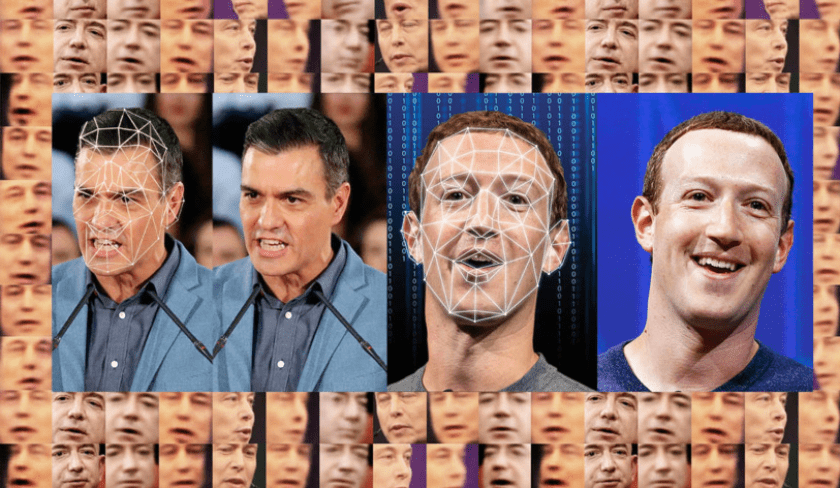

La mayor atención sobre el deepfake está puesta actualmente en las redes sociales y otros medios de comunicación. Cuanta más información visual y sonora exista sobre una persona, más posibilidades hay de hacer un video profundamente falso sobre él/ella. Por este motivo, los políticos y las celebridades del mundo artístico son el mayor objeto de este tipo de producción. Con ello puede fácilmente destruirse la reputación de un individuo difundiendo algún video falso por las redes sociales. Deeptrace, una empresa creada en 2018 y dedicada a detectar videos generados artificialmente, muestra en un estudio reciente que 96% del total de ellos –que tuvieron 134 millones de observaciones en línea– son pornográficos e involucran en su casi totalidad a celebridades femeninas en el mundo. En el aspecto social y político, esta tecnología puede influir sobre el actuar o el pensar de millones de personas. Es un instrumento más con el que la prensa puede manipular la opinión pública, práctica que siempre ha existido, pero de una manera mucho más peligrosa que hoy en día, pues el público tiene mayores dificultades para distinguir entre la verdad y la falsedad. Además, al poderse imitar la voz, las expresiones, y la manera de hablar de una persona específica, puede ponerse en serio riesgo a empresas y personas que reciben llamadas telefónicas u otras formas de comunicaciones sonoras de supuestos conocidos, amigos o familiares que en realidad no lo son. Existe el peligro de que sean inducidos a hacer negocios que no son seguros o pueden ser extorsionados haciéndoles pensar que han secuestrado a uno de sus seres queridos, sin que ello haya ocurrido.

Al mismo tiempo, esta tecnología se ha vuelto un instrumento para poner en duda la evidencia de algo verdadero. Por ejemplo, si alguien es incriminado por robo o por difamación o delitos más serios, el o la acusada pueden esgrimir el argumento de que han sido inculpados con base en videos falsos, aunque éstos sean auténticos. Se dificulta, así, la aplicación de la ley.

Y como suele ocurrir, la tecnología misma está atrasada para crear los antídotos de este peligroso instrumento y las regulaciones para su uso prácticamente no existen.

Comienza a haber medidas dispersas para limitar o controlar el uso de deepfake, pero hay mucho camino por andar aún. California prohibió crear o distribuir deepfakes desde dos meses antes de una elección para proteger a los votantes contra la desinformación y también permite al candidato afectado demandar ante la justicia a aquellos que producen este tipo de videos. Sin embargo, por la gran protección que existe al libre discurso y de expresión, al menos en Estados Unidos, es difícil aplicar la nueva ley. También se está considerando el uso de derechos de propiedad de cada individuo sobre su cara (similar a los derechos de autor o de propiedad intelectual). Pero esto sólo es aplicable después de que el daño ha sido hecho.

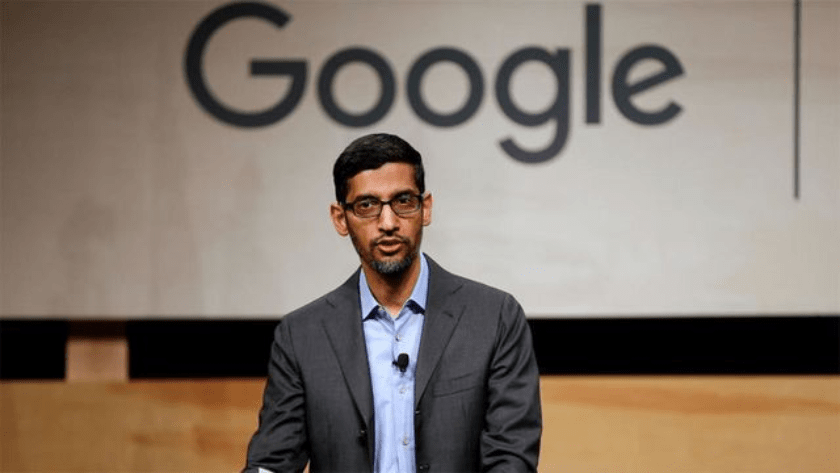

Algunos esperarían que las propias plataformas digitales se auto-regularan para evitar el uso de videos falsos y en la práctica esto ha comenzado a suceder pero en forma muy limitada. Hace unos días Sundar Pichai, Ejecutivo en Jefe de Alphabet y Google, manifestó que: Compañías como la nuestra no pueden simplemente generar nueva tecnología prometedora y dejar a las fuerzas del mercado que decidan como se usará. Es igualmente importante para nosotros asegurarnos que la tecnología se use para el bien y esté disponible para todos (traducción propia, Financial Times).

Facebook anunció en septiembre de 2019 que estaba contribuyendo con 10 millones de dólares a un fondo para mejorar la tecnología que detecta el deepfake y además anunciaron en enero de este año que prohibirían la exhibición de videos de este tipo, lo que es un paso importante pero aún insuficiente.

Ante la proximidad de las elecciones parlamentarias en Europa, llevadas a cabo en mayo de 2019, la Unión Europea adoptó iniciativas sugerentes y logró avances en sus esfuerzos por reducir la desinformación, apelando con energía a la cooperación de las grandes empresas tecnológicas. Sus esfuerzos se dirigieron a limitar los contenidos distorsionados de los medios de comunicación y redes, usualmente introducidos antes de las elecciones para sesgar los resultados. Dentro del Plan de Acción contra la Desinformación, la UE trabajó con las plataformas digitales y la industria para crear un Código Voluntario de Prácticas respecto a la desinformación con el fin de “aumentar la transparencia de la comunicaciones políticas y prevenir el uso manipulado de sus servicios”. Este Código incluía todo tipo de desinformación, no sólo deepfakes.

Entre enero y mayo de 2019, según un informe de la UE, las plataformas en línea adoptaron medidas para evitar la desinformación virtual a nivel mundial. Algunas de las acciones seguidas incluyeron la eliminación de 3.39 millones de canales de YouTube por parte de Google, por la violación de su política de spam (o correos no deseados) y políticas de interpretación distorsionantes. Facebook removió 2.19 mil millones informes falsos en el primer trimestre de 2019 y actuó específicamente contra 1,574 páginas no europeas y 168 páginas originadas en la UE. Twitter también actuó contra 77 millones de cuentas falsas o cuestionables a nivel mundial. Posteriormente Microsoft también se adhirió a la iniciativa.

Pero un estudio realizado por Avaaz y ISD (Institute for Strategic Dialogue), publicado en mayo de 2019, muestra que las grandes empresas tecnológicas se quedaron muy cortas respecto a lo que se habían comprometido a hacer en el Código de Conducta suscrito, cuyo objetivo era defender la democracia en Europa. El estudio dice, además, que las enormes irregularidades detectadas son probablemente sólo la punta del iceberg de toda la sensible desinformación que se manejó a través de dichas plataformas en el período pre-electoral.

Estamos, por tanto, ante un reto tecnológico y regulatorio sin precedentes. El deepfake está marcando un hito en la era de la post-verdad. Por el momento, al parecer, somos nosotros, los ciudadanos comunes y corrientes, los que necesitamos defendernos de la manipulación que se realiza a través de mecanismos que nuestros sentidos tienen cada vez menos posibilidades de diferenciar y discriminar. Pero el peligro va más allá, pues la forma en que se construye el entendimiento sobre lo que es público y común a todos puede ser manipulada por quienes controlan estas tecnologías por encima de nuestra voluntad.